AI 모델 평가 지표, 그 기준은?

AI와 머신러닝 모델을 개발하고 나면, 모델이 얼마나 잘 작동하는지 평가하는 것이 중요합니다. 다양한 모델 평가 지표는 모델의 성능을 다양한 관점에서 측정할 수 있게 해주며, 특히 분류 문제와 회귀 문제에서 각기 다른 지표를 사용합니다. 이 글에서는 모델을 평가할 때 사용할 수 있는 주요 지표들과 그 사용 방법, 각 지표의 의미를 자세히 알아보겠습니다.

1. 분류 모델의 평가 지표

분류 문제는 모델이 특정 입력 데이터가 어느 클래스에 속하는지 예측하는 문제입니다. 예를 들어, 이메일을 스팸과 정상 메일로 분류하거나, 이미지에서 개와 고양이를 구분하는 문제가 분류 문제에 해당합니다. 분류 모델의 성능을 평가하기 위해 주로 사용하는 지표는 다음과 같습니다.

정확도(Accuracy)

정확도는 모델이 정확하게 예측한 비율을 의미하며, 모든 예측 중 올바르게 예측한 횟수를 전체 예측 횟수로 나눈 값입니다.

정확도는 모델 성능을 간단하게 평가할 수 있는 지표이지만, 클래스가 불균형한 데이터(예: 질병 진단에서 환자가 적고 건강한 사람이 많은 경우)에서는 신뢰할 수 없는 결과를 줄 수 있습니다. 예를 들어, 95%가 건강한 사람인 데이터를 학습한 모델이 모든 예측을 ‘건강’으로 예측해도 정확도는 95%가 나오기 때문에, 이런 경우 정확도만으로는 모델의 성능을 평가하기 어렵습니다.

정밀도(Precision)와 재현율(Recall)

정밀도와 재현율은 특히 클래스가 불균형한 상황에서 유용한 평가 지표입니다.

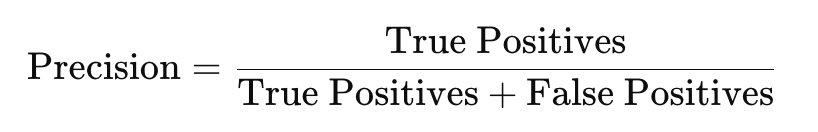

- 정밀도(Precision): 모델이 양성으로 예측한 결과 중 실제로 양성인 비율을 나타냅니다. 정밀도가 높으면, 모델이 양성으로 예측한 값들에 대한 신뢰도가 높다는 의미입니다.

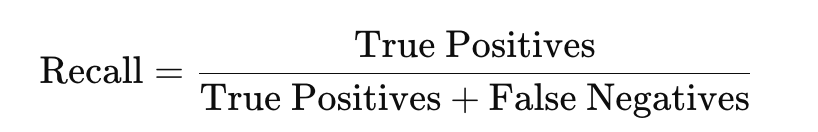

재현율(Recall): 실제 양성 중에서 모델이 양성으로 정확히 예측한 비율을 의미합니다. 재현율이 높다는 것은 실제 양성을 놓치지 않고 예측하는 능력이 높다는 것을 뜻합니다.

정밀도와 재현율은 상충 관계에 있습니다. 예를 들어, 정밀도가 높은 모델은 예측의 신뢰도가 높지만, 양성을 놓칠 수 있으며, 재현율이 높은 모델은 놓치는 양성 예측이 적지만 잘못 예측하는 경우가 있을 수 있습니다. 이러한 상황에서 균형 잡힌 평가를 위해 F1 점수를 사용할 수 있습니다.

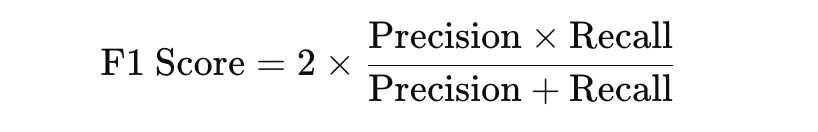

F1 점수(F1 Score)

F1 점수는 정밀도와 재현율의 조화 평균을 나타내며, 두 값이 균형을 이루도록 평가하는 지표입니다. 정밀도와 재현율 중 어느 한쪽에 치우치지 않고, 전반적인 성능을 평가할 때 유용합니다.

AUC-ROC 곡선(Area Under Curve - Receiver Operating Characteristic Curve)

AUC-ROC 곡선은 모델의 양성과 음성을 구분하는 능력을 시각적으로 평가하는 지표입니다. ROC 곡선은 모델의 **거짓 양성 비율(FPR)**에 대한 **참 양성 비율(TPR)**을 그래프로 표현한 것이며, AUC(Area Under Curve)는 이 곡선 아래의 면적을 의미합니다. AUC 값이 1에 가까울수록 모델의 분류 성능이 우수하다는 뜻입니다.

AUC-ROC는 특히 클래스 비율이 불균형한 문제에서 유용하게 사용되며, 모델의 임계값을 조정할 때 성능 변화를 관찰하는 데 도움을 줍니다.

2. 회귀 모델의 평가 지표

회귀 문제는 모델이 연속적인 값을 예측하는 문제로, 예를 들어 집값을 예측하거나 온도를 예측하는 문제에 사용됩니다. 회귀 모델의 성능을 평가할 때 사용하는 지표는 다음과 같습니다.

평균 제곱 오차(Mean Squared Error, MSE)

평균 제곱 오차는 예측 값과 실제 값의 차이를 제곱한 후 평균을 구한 값입니다. 오차의 제곱을 사용하기 때문에, 큰 오차가 있을 경우 패널티가 커져 모델의 예측 정확도가 낮아지게 됩니다.

MSE는 예측 값이 실제 값과 얼마나 가까운지를 평가할 수 있으며, 오차가 큰 경우 민감하게 반응합니다. 그러나 단위가 제곱 단위로 표현되기 때문에, 해석이 어렵다는 단점이 있습니다.

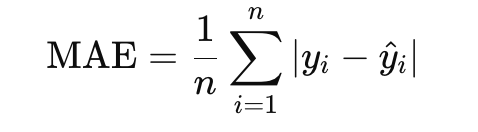

평균 절대 오차(Mean Absolute Error, MAE)

평균 절대 오차는 예측 값과 실제 값의 차이의 절댓값을 평균하여 계산한 값입니다. MAE는 MSE보다 해석이 쉬우며, 오차의 단위가 데이터와 동일하여 직관적으로 이해할 수 있습니다.

MAE는 오차의 크기를 직접적으로 반영하며, 이상치(outlier)에 덜 민감한 편입니다.

결정 계수(R-squared, R2R^2)

결정 계수는 회귀 모델이 데이터를 얼마나 잘 설명하는지를 나타내는 지표입니다. R2R^2 값은 0에서 1 사이의 값을 가지며, 1에 가까울수록 모델이 데이터를 잘 설명한다는 의미입니다.

R2R^2는 모델의 예측 값이 실제 값의 변동을 얼마나 잘 설명하는지를 나타내며, 회귀 모델의 성능을 평가하는 데 유용합니다. 다만, R2R^2 값이 1에 가까워도 과적합이 발생할 수 있기 때문에, 다른 지표와 함께 사용하는 것이 좋습니다.

평균 제곱근 오차(Root Mean Squared Error, RMSE)

평균 제곱근 오차는 MSE의 제곱근을 취한 값으로, 단위가 원래 데이터와 동일하기 때문에 해석이 용이합니다. RMSE는 큰 오차에 민감하게 반응하며, MSE와 MAE의 중간 정도의 평가 지표로 볼 수 있습니다.

3. 선택 기준: 어떤 지표를 사용할까?

모델 평가 시에는 하나의 지표에 의존하기보다, 여러 지표를 함께 사용하는 것이 좋습니다. 모델의 성능을 다각도로 평가할 수 있어, 신뢰할 수 있는 모델을 구축하는 데 도움이 됩니다.

- 분류 문제: 정확도, 정밀도, 재현율, F1 점수, AUC-ROC 중 상황에 맞는 지표를 선택합니다. 예를 들어, 클래스가 불균형한 문제에서는 정확도보다는 정밀도와 재현율을 중심으로 평가하는 것이 적절합니다.

- 회귀 문제: MSE, MAE, RMSE, R2R^2 등을 활용하여 회귀 모델의 예측 성능을 평가합니다. 오차의 크기를 줄이고자 할 때는 MSE나 RMSE를 사용하고, 모델의 설명력을 보고 싶다면 R2R^2를 참고할 수 있습니다.

4. 예시: 질병 진단 모델의 평가 지표 선택

예를 들어, 질병 진단 모델을 개발한다고 가정해 보겠습니다. 이 경우, 환자가 아닌 사람을 환자로 잘못 진단하는 것보다, 환자를 환자가 아니라고 잘못 판단하는 것이 더 치명적일 수 있습니다. 따라서 정확도보다는 **재현율(Recall)**이 중요한 지표가 됩니다. 재현율이 높을수록 실제 환자를 놓칠 확률이 줄어들기 때문입니다.

반면, 광고 추천 시스템의 경우에는 정밀도가 중요할 수 있습니다. 사용자에게 적합한 광고만 보여주는 것이 목적이기 때문에, 정밀도가 높아야 불필요한 광고를 줄이고 사용자 만족도를 높일 수 있습니다.

결론

AI와 머신러닝 모델의 성능을 평가하기 위해서는 다양한 지표를 이해하고, 문제에 적합한 지표를 선택하는 것이 중요합니다. 분류 문제와 회귀 문제에서는 각기 다른 지표가 사용되며, 한 가지 지표만으로 모델 성능을 평가하기보다는 여러 지표를 함께 고려하는 것이 바람직합니다. 이를 통해 모델의 성능을 다각도로 평가하고, 문제에 가장 적합한 지표를 사용하여 신뢰할 수 있는 모델을 구축할 수 있습니다.